In this case, there is a better option than making the plus lazy. We can use a greedy plus and a negated character class. The reason why this is better is because of the backtracking. When using the lazy plus, the engine has to backtrack for each character that it is trying to match.

这个关于注释的regex还真的不是看上去那么容易。我第一次就掉进了字符串的陷阱。

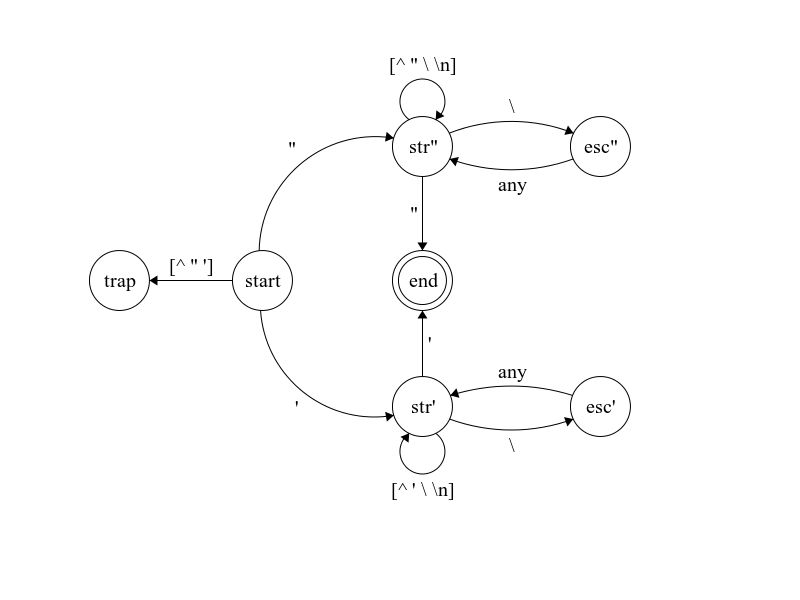

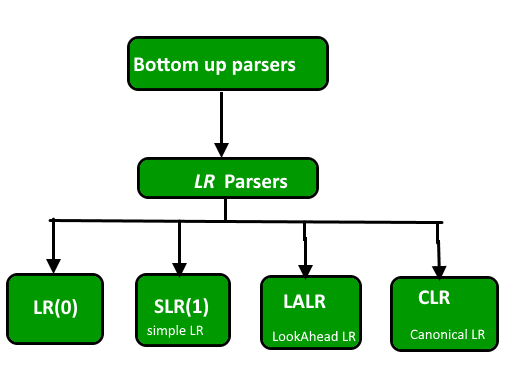

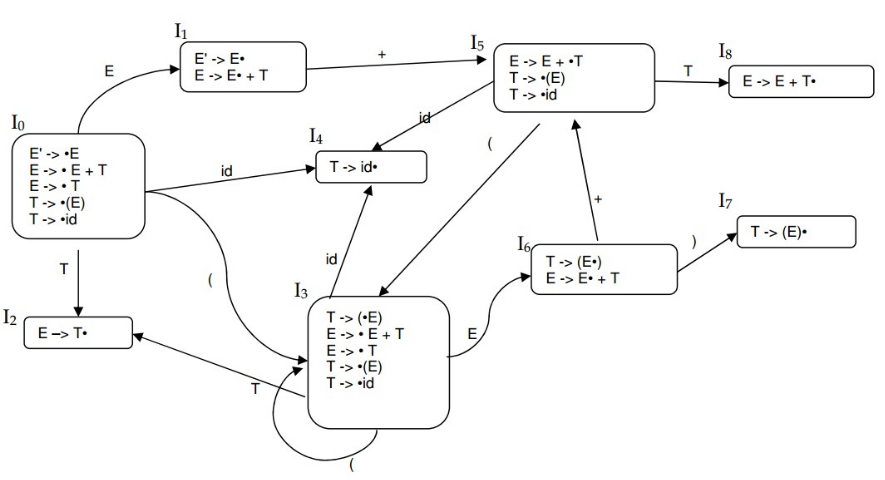

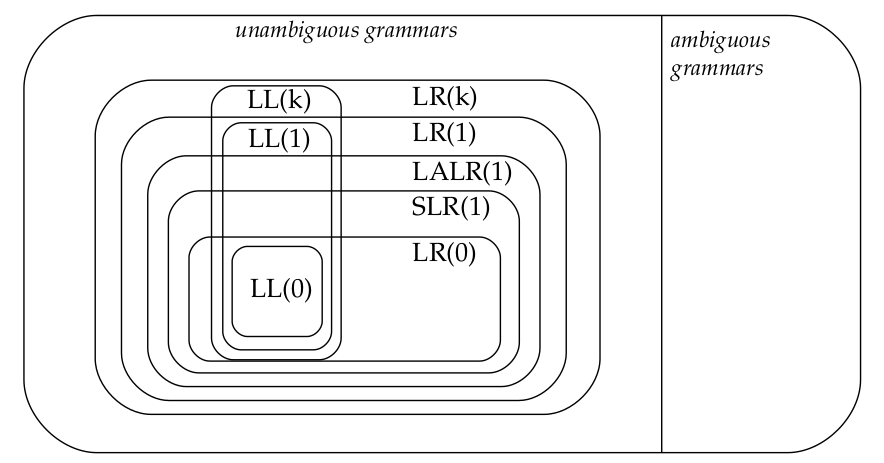

这个自动机要好好看看

这个自动机要好好看看

TL;DR

我对于大侠的帖子佩服不已,其中很多部分我还理解不了,保留一个版本。

我google了一下这个帖子还是被不少地方转载了,但是作者是否是原创我不是很肯定,但是这有什么关系呢?这个帖子的水平是很高的。

我查了一下boost::regex的文档关于backtrack control verb

Backtracking Control Verbs

This library has partial support for Perl's backtracking control verbs, in particular (*MARK) is not supported. There may also be detail differences in behaviour between this library and Perl, not least because Perl's behaviour is rather under-documented and often somewhat random in how it behaves in practice. The verbs supported are:

(*PRUNE)Has no effect unless backtracked onto, in which case all the backtracking information prior to this point is discarded.(*SKIP)Behaves the same as(*PRUNE)except that it is assumed that no match can possibly occur prior to the current point in the string being searched. This can be used to optimize searches by skipping over chunks of text that have already been determined can not form a match.(*THEN)Has no effect unless backtracked onto, in which case all subsequent alternatives in a group of alternations are discarded.(*COMMIT)Has no effect unless backtracked onto, in which case all subsequent matching/searching attempts are abandoned.(*FAIL)Causes the match to fail unconditionally at this point, can be used to force the engine to backtrack.(*ACCEPT)Causes the pattern to be considered matched at the current point. Any half-open sub-expressions are closed at the current point.

Lexing a source file is a good job for regexes. But for such a task, let's use a better regex engine than std::regex. Let's use PCRE (or boost::regex) at first. At the end of this post, I'll show what you can do with a less feature-packed engine.

We only need to do partial lexing, ignoring all unrecognized tokens that won't affect string literals. What we need to handle is:

- Singleline comments

- Multiline comments

- Character literals

- String literals

We'll be using the extended (x) option, which ignores whitespace in the pattern.

Comments

Here's what [lex.comment] says:

The characters

/*start a comment, which terminates with the characters*/. These comments do not nest. The characters//start a comment, which terminates immediately before the next new-line character. If there is a form-feed or a vertical-tab character in such a comment, only white-space characters shall appear between it and the new-line that terminates the comment; no diagnostic is required. [ Note: The comment characters//,/*, and*/have no special meaning within a//comment and are treated just like other characters. Similarly, the comment characters//and/*have no special meaning within a/*comment. — end note ]

# singleline comment

// .* (*SKIP)(*FAIL)

# multiline comment

| /\* (?s: .*? ) \*/ (*SKIP)(*FAIL)

Easy peasy. If you match anything there, just (*SKIP)(*FAIL) - meaning that you throw away the match. The (?s: .*? ) applies the s (singleline) modifier to the . metacharacter, meaning it's allowed to match newlines.

Character literals

Here's the grammar from [lex.ccon]:

character-literal: encoding-prefix(opt) ’ c-char-sequence ’ encoding-prefix: one of u8 u U L c-char-sequence: c-char c-char-sequence c-char c-char: any member of the source character set except the single-quote ’, backslash \, or new-line character escape-sequence universal-character-name escape-sequence: simple-escape-sequence octal-escape-sequence hexadecimal-escape-sequence simple-escape-sequence: one of \’ \" \? \\ \a \b \f \n \r \t \v octal-escape-sequence: \ octal-digit \ octal-digit octal-digit \ octal-digit octal-digit octal-digit hexadecimal-escape-sequence: \x hexadecimal-digit hexadecimal-escape-sequence hexadecimal-digit

Let's define a few things first, which we'll need later on:

(?(DEFINE)

(?<prefix> (?:u8?|U|L)? )

(?<escape> \\ (?:

['"?\\abfnrtv] # simple escape

| [0-7]{1,3} # octal escape

| x [0-9a-fA-F]{1,2} # hex escape

| u [0-9a-fA-F]{4} # universal character name

| U [0-9a-fA-F]{8} # universal character name

))

)

prefixis defined as an optionalu8,u,UorLescapeis defined as per the standard, except that I've mergeduniversal-character-nameinto it for the sake of simplicity

Once we have these, a character literal is pretty simple:

(?&prefix) ' (?> (?&escape) | [^'\\\r\n]+ )+ ' (*SKIP)(*FAIL)

We throw it away with (*SKIP)(*FAIL)

Simple strings

They're defined in almost the same way as character literals. Here's a part of [lex.string]:

string-literal: encoding-prefix(opt) " s-char-sequence(opt) " encoding-prefix(opt) R raw-string s-char-sequence: s-char s-char-sequence s-char s-char: any member of the source character set except the double-quote ", backslash \, or new-line character escape-sequence universal-character-name

This will mirror the character literals:

(?&prefix) " (?> (?&escape) | [^"\\\r\n]+ )* "

The differences are:

- The character sequence is optional this time (

*instead of+) - The double quote is disallowed when unescaped instead of the single quote

- We actually don't throw it away :)

Raw strings

Here's the raw string part:

raw-string: " d-char-sequence(opt) ( r-char-sequence(opt) ) d-char-sequence(opt) " r-char-sequence: r-char r-char-sequence r-char r-char: any member of the source character set, except a right parenthesis ) followed by the initial d-char-sequence (which may be empty) followed by a double quote ". d-char-sequence: d-char d-char-sequence d-char d-char: any member of the basic source character set except: space, the left parenthesis (, the right parenthesis ), the backslash \, and the control characters representing horizontal tab, vertical tab, form feed, and newline.

The regex for this is:

(?&prefix) R " (?<delimiter>[^ ()\\\t\x0B\r\n]*) \( (?s:.*?) \) \k<delimiter> "

[^ ()\\\t\x0B\r\n]*is the set of characters that are allowed in delimiters (d-char)\k<delimiter>refers to the previously matched delimiter

The full pattern

The full pattern is:

(?(DEFINE)

(?<prefix> (?:u8?|U|L)? )

(?<escape> \\ (?:

['"?\\abfnrtv] # simple escape

| [0-7]{1,3} # octal escape

| x [0-9a-fA-F]{1,2} # hex escape

| u [0-9a-fA-F]{4} # universal character name

| U [0-9a-fA-F]{8} # universal character name

))

)

# singleline comment

// .* (*SKIP)(*FAIL)

# multiline comment

| /\* (?s: .*? ) \*/ (*SKIP)(*FAIL)

# character literal

| (?&prefix) ' (?> (?&escape) | [^'\\\r\n]+ )+ ' (*SKIP)(*FAIL)

# standard string

| (?&prefix) " (?> (?&escape) | [^"\\\r\n]+ )* "

# raw string

| (?&prefix) R " (?<delimiter>[^ ()\\\t\x0B\r\n]*) \( (?s:.*?) \) \k<delimiter> "

See the demo here.

boost::regex

Here's a simple demo program using boost::regex:

#include <string>

#include <iostream>

#include <boost/regex.hpp>

static void test()

{

boost::regex re(R"regex(

(?(DEFINE)

(?<prefix> (?:u8?|U|L) )

(?<escape> \\ (?:

['"?\\abfnrtv] # simple escape

| [0-7]{1,3} # octal escape

| x [0-9a-fA-F]{1,2} # hex escape

| u [0-9a-fA-F]{4} # universal character name

| U [0-9a-fA-F]{8} # universal character name

))

)

# singleline comment

// .* (*SKIP)(*FAIL)

# multiline comment

| /\* (?s: .*? ) \*/ (*SKIP)(*FAIL)

# character literal

| (?&prefix)? ' (?> (?&escape) | [^'\\\r\n]+ )+ ' (*SKIP)(*FAIL)

# standard string

| (?&prefix)? " (?> (?&escape) | [^"\\\r\n]+ )* "

# raw string

| (?&prefix)? R " (?<delimiter>[^ ()\\\t\x0B\r\n]*) \( (?s:.*?) \) \k<delimiter> "

)regex", boost::regex::perl | boost::regex::no_mod_s | boost::regex::mod_x | boost::regex::optimize);

std::string subject(R"subject(

std::cout << L"hello" << " world";

std::cout << "He said: \"bananas\"" << "...";

std::cout << "";

std::cout << "\x12\23\x34";

std::cout << u8R"hello(this"is\a\""""single\\(valid)"

raw string literal)hello";

"" // empty string

'"' // character literal

// this is "a string literal" in a comment

/* this is

"also inside"

//a comment */

// and this /*

"is not in a comment"

// */

"this is a /* string */ with nested // comments"

)subject");

std::cout << boost::regex_replace(subject, re, "String\\($&\\)", boost::format_all) << std::endl;

}

int main(int argc, char **argv)

{

try

{

test();

}

catch(std::exception ex)

{

std::cerr << ex.what() << std::endl;

}

return 0;

}

(I left syntax highlighting disabled because it goes nuts on this code)

For some reason, I had to take the ? quantifier out of prefix (change (?<prefix> (?:u8?|U|L)? ) to (?<prefix> (?:u8?|U|L) ) and (?&prefix) to (?&prefix)?) to make the pattern work. I believe it's a bug in boost::regex, as both PCRE and Perl work just fine with the original pattern.

What if we don't have a fancy regex engine at hand?

Note that while this pattern technically uses recursion, it never nests recursive calls. Recursion could be avoided by inlining the relevant reusable parts into the main pattern.

A couple of other constructs can be avoided at the price of reduced performance. We can safely replace the atomic groups (?>...) with normal groups (?:...) if we don't nest quantifiers in order to avoid catastrophic backtracking.

We can also avoid (*SKIP)(*FAIL) if we add one line of logic into the replacement function: All the alternatives to skip are grouped in a capturing group. If the capturing group matched, just ignore the match. If not, then it's a string literal.

All of this means we can implement this in JavaScript, which has one of the simplest regex engines you can find, at the price of breaking the DRY rule and making the pattern illegible. The regex becomes this monstrosity once converted:

(\/\/.*|\/\*[\s\S]*?\*\/|(?:u8?|U|L)?'(?:\\(?:['"?\\abfnrtv]|[0-7]{1,3}|x[0-9a-fA-F]{1,2}|u[0-9a-fA-F]{4}|U[0-9a-fA-F]{8})|[^'\\\r\n])+')|(?:u8?|U|L)?"(?:\\(?:['"?\\abfnrtv]|[0-7]{1,3}|x[0-9a-fA-F]{1,2}|u[0-9a-fA-F]{4}|U[0-9a-fA-F]{8})|[^"\\\r\n])*"|(?:u8?|U|L)?R"([^ ()\\\t\x0B\r\n]*)\([\s\S]*?\)\2"

And here's an interactive demo you can play with:

function run() {

var re = /(\/\/.*|\/\*[\s\S]*?\*\/|(?:u8?|U|L)?'(?:\\(?:['"?\\abfnrtv]|[0-7]{1,3}|x[0-9a-fA-F]{1,2}|u[0-9a-fA-F]{4}|U[0-9a-fA-F]{8})|[^'\\\r\n])+')|(?:u8?|U|L)?"(?:\\(?:['"?\\abfnrtv]|[0-7]{1,3}|x[0-9a-fA-F]{1,2}|u[0-9a-fA-F]{4}|U[0-9a-fA-F]{8})|[^"\\\r\n])*"|(?:u8?|U|L)?R"([^ ()\\\t\x0B\r\n]*)\([\s\S]*?\)\2"/g;

var input = document.getElementById("input").value;

var output = input.replace(re, function(m, ignore) {

return ignore ? m : "String(" + m + ")";

});

document.getElementById("output").innerText = output;

}

document.getElementById("input").addEventListener("input", run);

run();<h2>Input:</h2>

<textarea id="input" style="width: 100%; height: 50px;">

std::cout << L"hello" << " world";

std::cout << "He said: \"bananas\"" << "...";

std::cout << "";

std::cout << "\x12\23\x34";

std::cout << u8R"hello(this"is\a\""""single\\(valid)"

raw string literal)hello";

"" // empty string

'"' // character literal

// this is "a string literal" in a comment

/* this is

"also inside"

//a comment */

// and this /*

"is not in a comment"

// */

"this is a /* string */ with nested // comments"

</textarea>

<h2>Output:</h2>

<pre id="output"></pre>prefix(optional) R"delimiter(raw_characters)delimiter"这里的prefix是其中任意一个L, u8, u, U

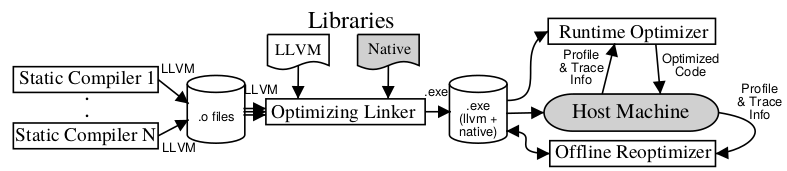

我以前对于llvm使用原系统的linker的原因依然不是很理解,也许是没有必要,或者不现实,因为你部署自己的linker相当于改变了整个操作系统的完整性,这个和自己创建虚拟机有什么不同?但是部署自己的虚拟机如jvm那样是对于用户的大的负担吧?但是要去动态修改代码那肯定是要部署自己作为虚拟机了吧?

我以前对于llvm使用原系统的linker的原因依然不是很理解,也许是没有必要,或者不现实,因为你部署自己的linker相当于改变了整个操作系统的完整性,这个和自己创建虚拟机有什么不同?但是部署自己的虚拟机如jvm那样是对于用户的大的负担吧?但是要去动态修改代码那肯定是要部署自己作为虚拟机了吧?

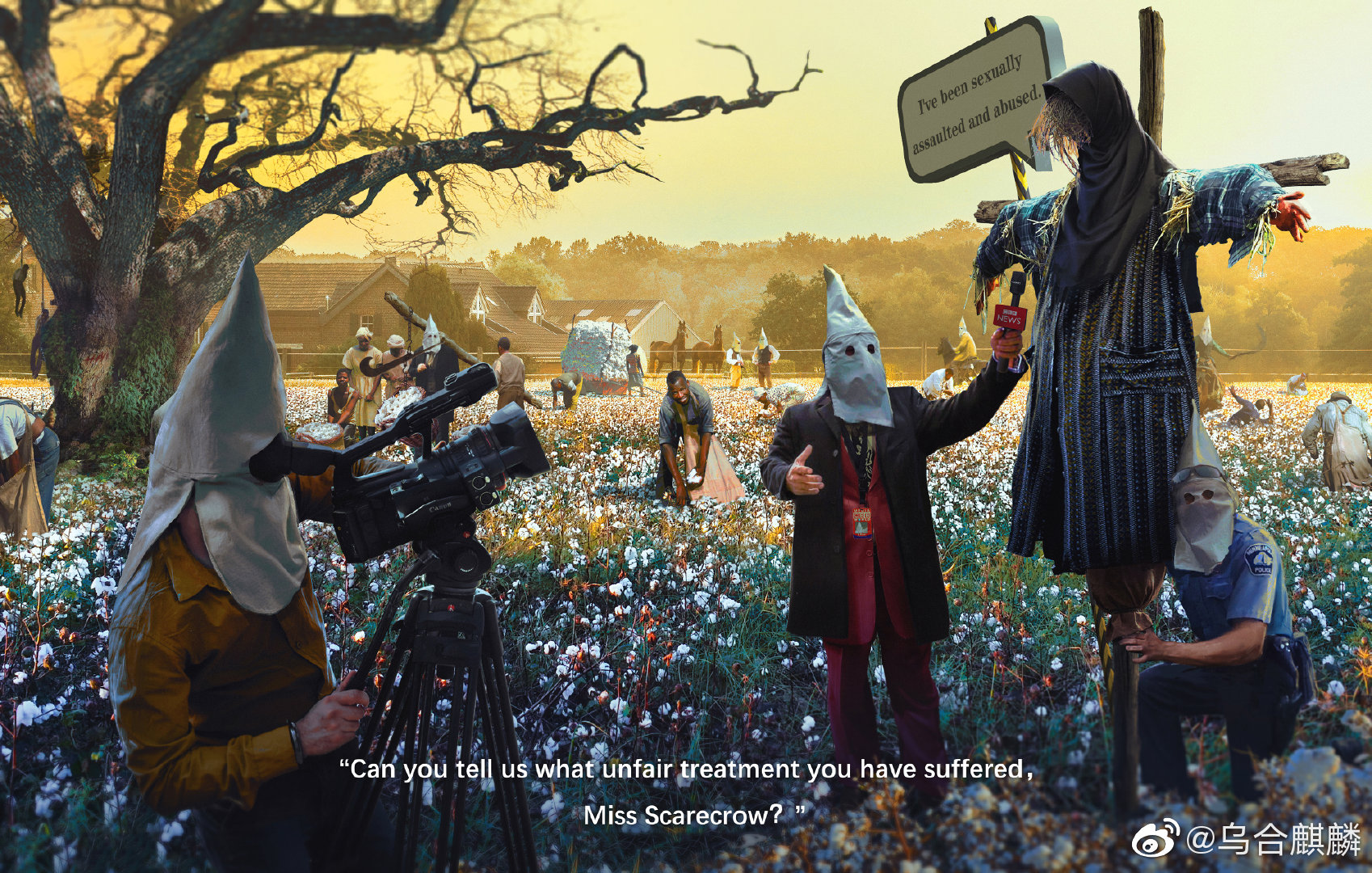

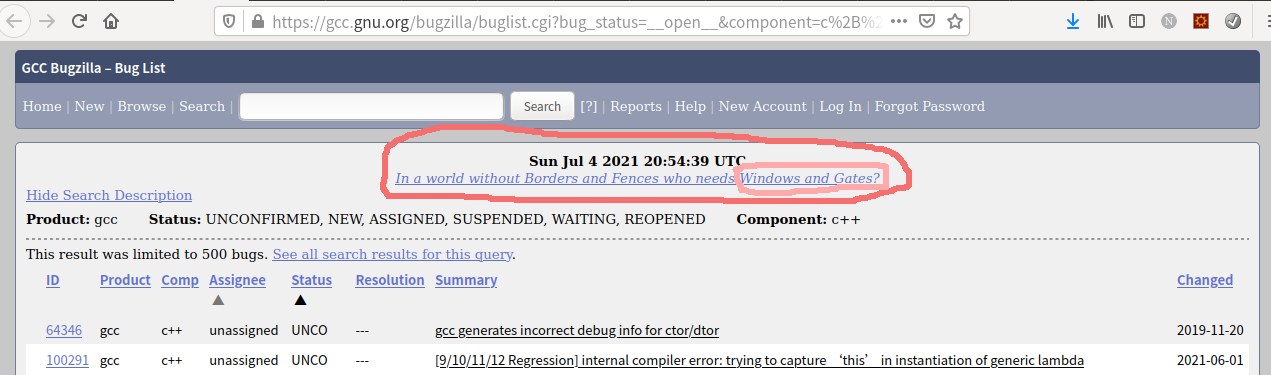

很明显的GCC是一个反对微软的政治组织?哈哈,在

很明显的GCC是一个反对微软的政治组织?哈哈,在

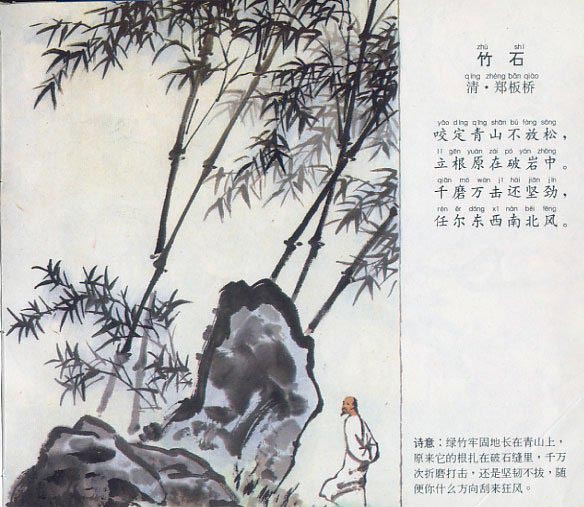

我一时好奇google要如何把这首小诗翻译成英文呢?比我想像的好太多了,相当的不错!

我一时好奇google要如何把这首小诗翻译成英文呢?比我想像的好太多了,相当的不错!

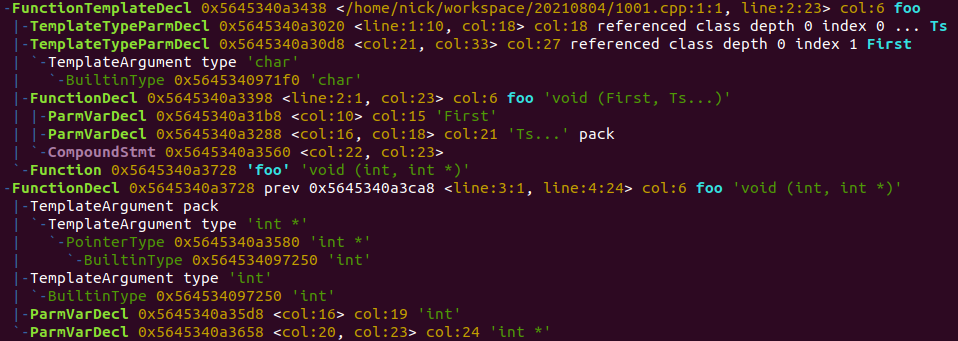

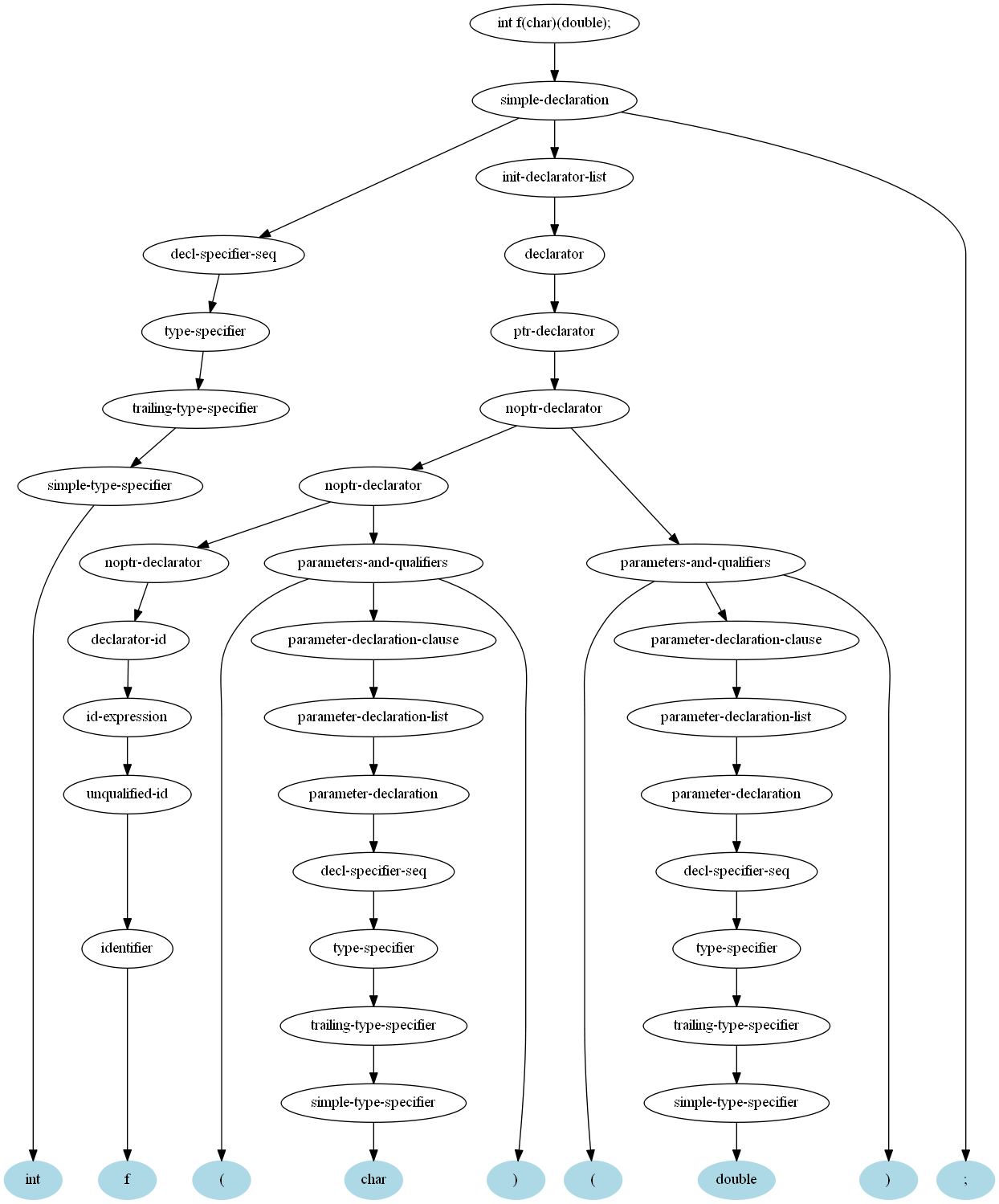

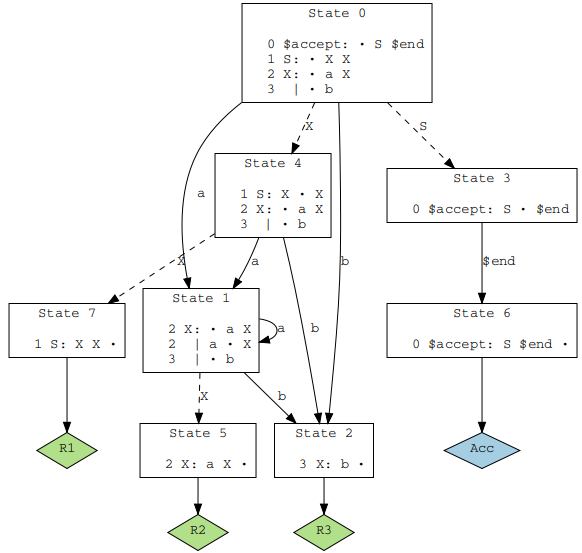

我使用xdot打开bison产生的.dot文件,但是xdot没有输出到文件的功能,因为打印输出的图像总是偏在一边,只好用截图来保存。xdot还有很智能的部分很可惜不能输出svg图形。

我使用xdot打开bison产生的.dot文件,但是xdot没有输出到文件的功能,因为打印输出的图像总是偏在一边,只好用截图来保存。xdot还有很智能的部分很可惜不能输出svg图形。

教授特别点出这一点:

教授特别点出这一点: 我不知道这个鬼字符是怎么来的也许是编码垃圾?最后只能

我不知道这个鬼字符是怎么来的也许是编码垃圾?最后只能